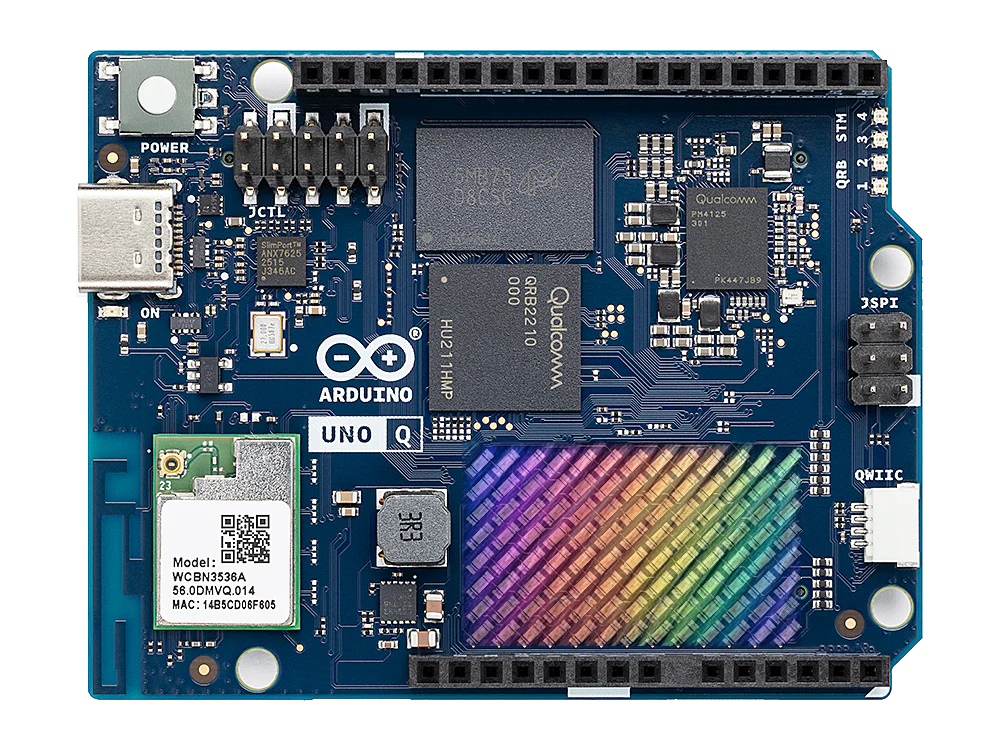

L’Arduino UNO Q marque une révolution pour la plateforme Arduino, fusionnant la simplicité du prototypage open-source avec la puissance de l’edge computing. Fruit d’un partenariat avec Qualcomm, cette carte hybride exécute Linux tout en restant compatible avec les shields et projets Arduino classiques. Conçue comme une boîte à outils tout-en-un, elle combine un microprocesseur Qualcomm pour le calcul intensif (IA, vision, réseau) et un microcontrôleur STM32 pour le contrôle temps réel. Elle s’adresse aux makers, éducateurs et développeurs industriels, ouvrant la voie à des innovations futures.

En octobre 2025, Qualcomm a racheté Arduino pour booster l’informatique de pointe (edge computing), c’est-à-dire traiter les données près de là où elles sont créées, comme dans une smartwatch ou un robot, pour des projets de makers et des machines industrielles. De cette collaboration est né l’UNO Q, le premier produit combinant la puissance et la connectivité des puces Qualcomm avec la simplicité et l’approche open-source d’Arduino. Avec ses 33 millions d’utilisateurs, la communauté reste au cœur du projet, avec la promesse de schémas et fichiers Gerber accessibles à tous – ces derniers étant des « plans » précis que les machines lisent pour fabriquer des circuits électroniques.

Une architecture « Dual-Brain » : puissance et réactivité

L’UNO Q repose sur une architecture dual-processor unique :

- Processeur Qualcomm Dragonwing QRB2210 :

- Quad-core ARM Cortex-A53 64-bit @ 2.0 GHz (11 nm).

- GPU Adreno 702 + ISP Spectra (2×13 MP ou 25 MP @ 30 fps).

- Hexagon DSP pour accélération IA (TensorFlow Lite, Edge Impulse) et audio.

- OS : Debian Linux natif (support Docker pour apps conteneurisées).

- Usage : vision embarquée, scripts Python/Node, serveurs IoT locaux.

- Microcontrôleur STM32U585 :

- ARM Cortex-M33 @ 160 MHz, 2 Mo Flash, 786 Ko SRAM.

- Tâches : contrôle moteurs, capteurs, PWM, logique déterministe.

- Sécurité : AES/SHA, TRNG pour chiffrement.

- OS : Zephyr RTOS avec Arduino Bridge pour sketches classiques.

- Basse consommation : ~1W en veille.

Les deux cœurs communiquent via un bus SPI dédié (~10-20 MHz), orchestré par Arduino Bridge, une couche logicielle simplifiant les échanges (ex. : détections IA vers actions moteur). Le MCU garantit le temps réel via Zephyr RTOS (scheduler préemptif, priorités IRQ, watchdog matériel), avec une latence estimée <1ms pour PWM (théoriques et sous conditions optimales).

Spécifications techniques

| Composant | Détail |

|---|---|

| MPU | Qualcomm Dragonwing QRB2210 (Quad-core Cortex-A53 @ 2.0 GHz) |

| MCU | STM32U585 Cortex-M33 @ 160 MHz |

| RAM | 2 Go LPDDR4 |

| Stockage | 16 Go eMMC (slot microSD optionnel, jusqu’à 1 To) |

| Wi-Fi | 802.11ac (dual-band 2.4/5 GHz) |

| Bluetooth | 5.1 (BLE + classic) |

| USB | 1× USB-C OTG (Power Delivery, sortie vidéo, périphériques comme clavier/souris/micro/cam via dongle) |

| GPIO | Brochage UNO R3 (14 I/O numériques, 6 analogiques) |

| Caméras | 2× MIPI-CSI |

| Affichage | DSI via adaptateur, USB-C alt mode possible (non confirmé) |

| Alimentation | USB-C 5V/3A ou VIN 7–12V |

| Consommation | ~3.5W usage mixte, ~1W idle |

| Connectique | Qwiic (I²C), header ventilateur 5V, JTAG |

| Extras | Matrice LED 8×13 (debug/UI), capteur température, 4× LED RGB |

| Format | UNO R3 (shields compatibles) |

| Température | 0 °C à +70 °C |

Note : Performances (latences, FPS) basées sur specs similaires ou tests préliminaires. A vérifier selon le firmware sur docs.arduino.cc.

Premiers Pas

- Flash initial : Branchez la carte via USB-C et utilisez App Lab (compatible Windows, Mac, Linux) pour installer Debian ou Zephyr.

- Mises à jour OTA : Gérées via Foundries.io (par Wi-Fi).

- Premier projet : Essayez le modèle App Lab « Détection d’objets » (avec caméra et moteur).

- Ressources : Consultez les docs Arduino, le forum communautaire ou le store (environ 44 € pour la version de base).

Design matériel optimisé

- PCB : 6 couches, plan de masse pour faible EMI et dissipation thermique.

- RF : Antenne Wi-Fi/BT intégrée avec filtre EMI.

- Énergie : Régulateurs buck-boost, support Power-over-USB-C (PD).

- Multimédia : GPU Adreno + ISP Spectra pour encodage/décodage matériel.

- Sécurité : Enclaves sécurisées MPU/MCU, TRNG pour entropie.

Comparaison : UNO Q vs. UNO R3 vs. Raspberry Pi 5

| Caractéristique | Arduino UNO R3 | Arduino UNO Q | Raspberry Pi 5 |

|---|---|---|---|

| Processeur | ATmega328P (8-bit, 16 MHz) | QRB2210 + STM32U585 | Cortex-A76 quad @ 2.4 GHz |

| Architecture | MCU seul | Dual MPU/MCU | MPU seul |

| RAM | 2 Ko | 2 Go LPDDR4 | 4–8 Go LPDDR4X |

| Stockage | 32 Ko Flash | 16 Go eMMC + microSD | microSD (NVMe via PCIe) |

| Connectivité | Aucune | Wi-Fi 5, BT 5.1 | Wi-Fi 6, BT 5.0, Gigabit Ethernet |

| Caméra/GPU | Non | Adreno 702, 2× MIPI-CSI | VideoCore VII |

| AI/ML | Non | TensorFlow Lite, OpenCV | TensorFlow, OpenCV |

| GPIO | UNO (14+6) | UNO (14+6) | 40-pin polyvalent |

| OS | Aucun | Debian + Zephyr RTOS | Linux (Raspbian) |

| Conso | ~0.5W | ~3.5W | ~5-7W |

| Prix | ~20-25 € | ~44-59 € | ~60-80 € |

| Usage | Éducation, capteurs | Robotique, IA, IoT | Serveurs, multimédia |

UNO Q excelle en contrôle temps réel hybride (latence estimée <1ms vs. 5-10ms pour Pi 5 en tâches moteurs) et IA embarquée légère (ex. : YOLOv5-nano ~10-15 FPS, tests Cortex-A53 similaires). Pi 5 domine en multimédia et serveurs grâce à son GPU et Ethernet natif.

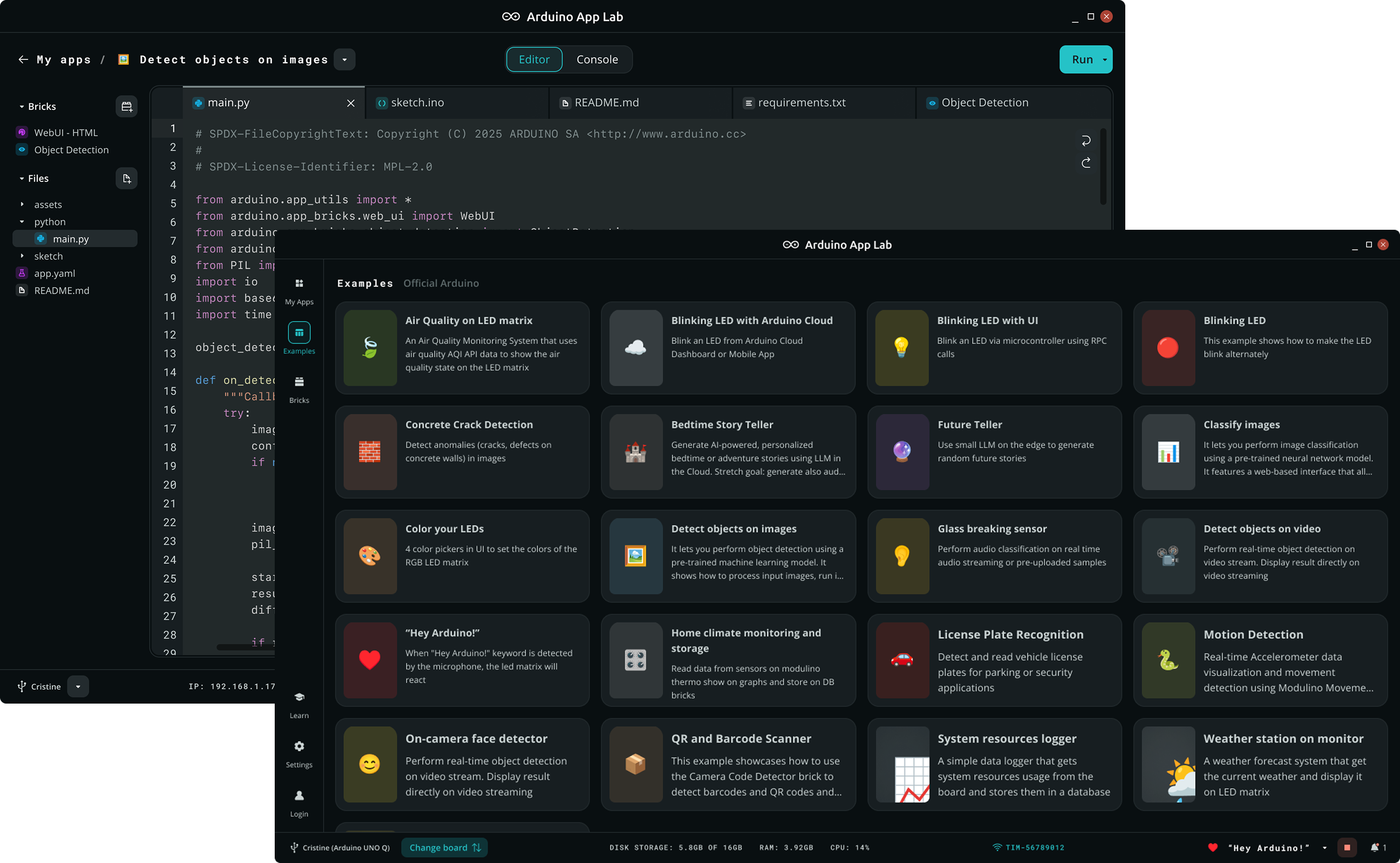

Arduino App Lab : prototypage rapide

L’UNO Q inclut Arduino App Lab, un IDE unifié (préinstallé, accessible via Wi-Fi/USB-C) pour programmer le MPU (Python/Node) et le MCU (Arduino C++/Zephyr). Il propose :

- Templates : détection d’objets (YOLO), reconnaissance vocale, IoT MQTT.

- Support : TensorFlow Lite Micro (MCU), OpenCV (MPU), Edge Impulse (ML ops).

- Inclut des ‘Apps’ (exemples autonomes prêts à l’emploi) et ‘Bricks’ (fonctionnalités plug-and-play), avec modèles AI pré-chargés pour détection objets/humains, anomalies, classification image/son et keyword spotting.

- Headless mode : configuration via navigateur pour projets distants.

Exemple simple (détection objet + action moteur) :

// MCU : Trigger PWM si objet détecté (via MPU)

#include <ArduinoBridge.h>

void setup() {

pinMode(9, OUTPUT); // PWM moteur

Bridge.begin(); // Init com MPU-MCU

}

void loop() {

if (Bridge.readObjectDetected()) { // Objet vu par YOLO

analogWrite(9, 255); // Moteur ON

} else {

analogWrite(9, 0);

}

delay(10);

}IA et vision embarquées

- Vision : Classification d’images (TensorFlow Lite, estimé ~10-15 FPS pour YOLOv5-nano, optimisé via GPU Adreno/DSP Hexagon), détection d’objets (OpenCV accéléré). Pilotes MIPI-CSI en bêta (octobre 2025), mises à jour OTA prévues. Modèles pré-chargés pour détection objets/humains, anomalies, classification image/son et keyword spotting, sans envoi cloud.

- Audio : Reconnaissance vocale locale, détection d’événements sonores.

- Avantage : Pas de cloud, latence <100ms pour actions couplées (ex. : moteur activé sur détection).

Extensibilité : shields et Qwiic

- Shields UNO R3 : Compatibilité physique totale (ex. : Motor Shield, Sensor Shield).

- Qwiic (I²C) : Branchement rapide de capteurs/modules sans soudure (ex. : SparkFun ToF, OLED), pour Modulino® nodes et modules tiers.

- Extras : Header ventilateur 5V, JTAG pour debug, matrice LED 8×13 pour UI simple. Bénéficie des bibliothèques, sketches et projets développés par des millions d’utilisateurs de l’écosystème UNO.

Cas d’usage et idées de projets avancés

L’UNO Q ouvre la voie à des projets combinant IA, vision, IoT et contrôle temps réel :

- Robot autonome à vision IA : Caméra MIPI-CSI (ex. : OV5647) avec YOLOv5-nano (App Lab) pour détecter obstacles/lignes, shield moteur (L298N) piloté par le MCU (<1ms). Idéal pour robotique éducative ou industrielle.

- Station IoT sécurisée : Capteurs Qwiic (ex. : BME680 pour température/vibrations), chiffrement AES/TRNG, envoi Wi-Fi (MQTT). Stockage local (eMMC/microSD) pour monitoring sans cloud.

- Caméra intelligente : Détection mouvement/objet (OpenCV, MPU) avec caméra 13MP, clips sur eMMC, alertes via buzzer Qwiic (MCU). Parfait pour smart home/sécurité.

- Assistant vocal domotique : Micro (ex. : INMP441) pour reconnaissance vocale (Edge Impulse), contrôle de relais (lumières/moteurs) via GPIO, affichage sur OLED Qwiic.

- Lab éducatif IA/robotique : Projets pédagogiques mêlant Python (MPU, vision couleur) et C++ (MCU, moteurs/capteurs). Exemple : robot triant objets par couleur.

Astuce : Utilisez App Lab pour des templates (vision, IoT, audio) et la compatibilité shields/Qwiic pour un prototypage rapide. Partagez vos créations sur forum.arduino.cc !

Avantages et limites

Avantages :

- Puissance (IA, vision) + contrôle temps réel.

- App Lab accélère le prototypage, avec modèles AI et exemples pré-chargés pour un démarrage instantané.

- Compatibilité shields + Qwiic.

- Consommation optimisée (~1W idle).

Limites :

- 1× USB-C (hub requis pour multi-périphériques).

- Pas d’Ethernet/HDMI natifs.

- GPU moins puissant que Pi 5 pour multimédia.

- Écosystème jeune : Pilotes MIPI-CSI/DSI en bêta (octobre 2025), pouvant limiter stabilité/résolution. OTA via Foundries.io sans calendrier fixe. Support long terme lié à Qualcomm/Arduino (schémas open-source confirmés). Testez via App Lab et suivez forum.arduino.cc.

Conclusion

L’Arduino UNO Q combine la réactivité de l’Arduino classique avec la puissance de Linux, offrant une plateforme ouverte pour la robotique, l’IA locale et l’IoT. Grâce à App Lab et sa compatibilité avec les shields et connecteurs Qwiic, elle reste accessible. Bien que son écosystème soit en maturation, elle sert de pont entre l’éducation et l’industrie, avec un potentiel futur immense : robots autonomes apprenants, maisons intelligentes, outils agricoles automatisés. Soutenue par Qualcomm et la communauté Arduino, elle pourrait devenir une référence pour l’innovation.

Soutenez le site et lancez vos projets avec l’UNO Q !

Vous avez aimé cet article ? Aidez le site et partagez des tutos et analyses sur le hardware open-source via un don financier ou en offrant un Arduino UNO Q pour de futurs projets (contactez via le formulaire du site). Imaginez les possibilités : robots autonomes avec vision IA, stations IoT sécurisées ou labs éducatifs mêlant C++ et Python. Ensemble, faisons vivre la communauté maker !